pythonは数列を作るには便利な言語じゃないかなぁ。こういうかんじ、プログラミングならではとおもう。鉛筆で、ひとつひとつ書いていくのは、たいへんすぎるやろ。

numpy(モジュール)をインポートする。

![]()

リストをつくる

![]()

値を入れる

![]()

アウトプットする。

![]()

![]()

もうひとつ、リストをつくる。

![]()

my_list1とmy_list2をリストする。

![]()

アウトプットする。

![]()

![]()

ゼロを5つ、ならべてみよう。

![]()

アウトプット。

![]()

そのデータの種類は、なんだ?

![]()

![]()

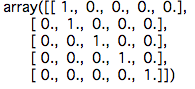

こんなこともできる。

![]()

アウトプット。

ゼロから5まで、ならべてみる。

![]()

アウトプット

![]()

5からはじまり、順番に50個の要素を取り出し、さらに2つ置きにならべる。

![]()

アウトプット。

![]()